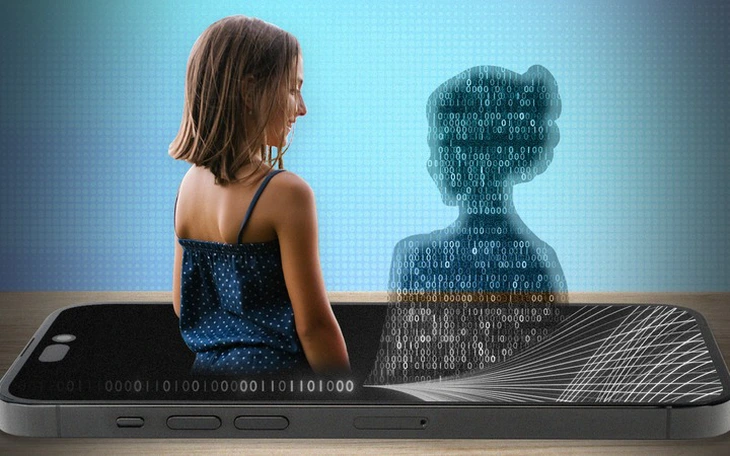

Trong lĩnh vực AI, "nịnh hót" (sycophancy) ám chỉ xu hướng chatbot đồng ý hoặc tán dương người dùng một cách quá mức - Ảnh: REUTERS

Theo báo SCMP, các mô hình  Anh: Nhiều nam sinh tìm đến AI để có... 'bạn gái ảo' tâm sự và trị liệu tâm lýĐỌC NGAY

Anh: Nhiều nam sinh tìm đến AI để có... 'bạn gái ảo' tâm sự và trị liệu tâm lýĐỌC NGAY

Kết quả cho thấy mô hình Qwen2.5-7B-Instruct của Alibaba Cloud là mô hình "nịnh bợ" nhất, khi ủng hộ người đăng bài trong 79% trường hợp, dù cộng đồng đánh giá người đó sai. Xếp thứ hai là DeepSeek-V3 với tỉ lệ 76%.

Trong khi đó Gemini-1.5 của Google DeepMind thể hiện mức độ nịnh thấp nhất, chỉ 18% trường hợp mâu thuẫn với đánh giá của cộng đồng.

Các nhà nghiên cứu cảnh báo rằng AI có xu hướng "nịnh" người dùng có thể khiến họ ít sẵn sàng hòa giải hoặc nhận lỗi trong các mối quan hệ.

Thậm chí người dùng lại thường đánh giá cao và tin tưởng hơn những phản hồi mang tính nịnh bợ, khiến các mô hình này dễ được ưa chuộng và sử dụng rộng rãi.

"Những sở thích này tạo ra động lực lệch lạc - người dùng ngày càng phụ thuộc vào AI nịnh bợ, và các nhà phát triển sẽ có xu hướng huấn luyện mô hình theo hướng đó" - nhóm nghiên cứu nhận định.

Theo giáo sư Jack Jiang, Giám đốc Phòng thí nghiệm đánh giá AI tại Trường Kinh doanh Đại học Hong Kong, hiện tượng này cũng tiềm ẩn rủi ro với doanh nghiệp: "Nếu một mô hình luôn đồng ý với kết luận của nhà phân tích kinh doanh, điều đó có thể dẫn đến những quyết định sai lầm và thiếu an toàn".

Vấn đề "nịnh hót" của AI từng gây chú ý hồi tháng 4-2025, khi bản cập nhật ChatGPT của OpenAI được cho là quá lễ phép và đồng tình quá mức với mọi ý kiến của người dùng.

OpenAI sau đó lên tiếng thừa nhận điều này có thể ảnh hưởng đến sức khỏe tâm lý và cam kết cải thiện quy trình đánh giá trước khi phát hành phiên bản mới.

Chuyên gia báo động tình trạng người trẻ 'phải lòng' chatbot AI

Chuyên gia báo động tình trạng người trẻ 'phải lòng' chatbot AI